責任あるAIとは?

BCGによる責任あるAIの導入支援

現在、「責任あるAI」という戦略的アプローチを本格的に取り入れている企業はまだ多くありません。一部の企業にとっては、構想から実行へ移すハードルが高く感じられることが、導入が進まない要因になっています。また、AIに関する規制がどのような形で整備されるのかを見極めようとして、導入を見送っている企業もあります。しかし責任あるAIの実践は、将来の規制対応だけでなく、いま現在のビジネスにも確かな価値をもたらします。

BCGの実践的なRAIフレームワークは、責任あるAIの成熟度を高めるまでの時間を最小限に抑えながら、その価値を最大化します。次の5つの柱を基盤としており、各組織の現状や文化に応じて柔軟に適用することができます。

「責任あるAI」戦略

AIガバナンス

カギとなるプロセス

テクノロジーとツール

カルチャー

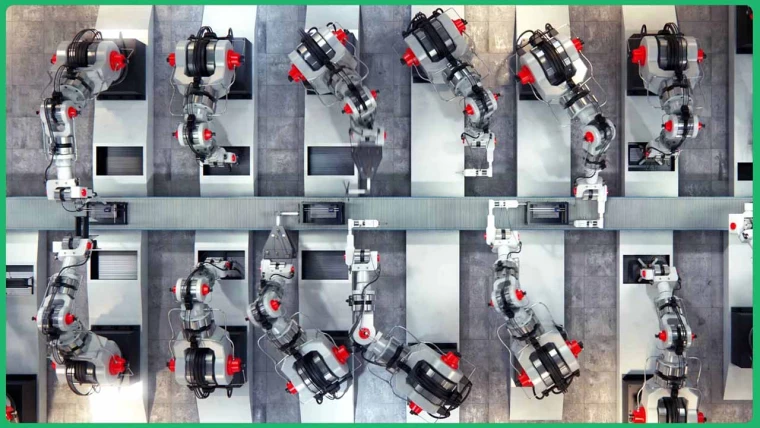

責任あるAIに関するBCGのクライアント支援事例

責任あるAIを専門とするBCGのコンサルタントは、世界各国のさまざまな業界の企業と協働し、透明性を担保しながらビジネス上の価値を生み出す最適なソリューションを構築しています。

責任あるAIに関するBCGのツールとソリューション

「責任あるAI」成熟度評価

「責任あるAI」成熟度評価

Facet By BCG X

生成AIシステム評価

生成AIシステム評価

ARTKITのご紹介

ARTKITはBCG Xが開発したオープンソースのツールキットで、新しい生成AIシステムを「レッドチーミング(脆弱性検証)」するためのものです。このツールを使うことで、データサイエンティスト、エンジニア、ビジネスリーダーは、革新的な生成AIの概念実証(PoC)から、信頼性の高いエンタープライズ規模のソリューションとして市場に展開するまでのギャップを迅速に埋めることができます。ARTKITは、人の手による検証と自動テストを組み合わせ、次の観点から新しい生成AIシステムを検証する実践的なツールを提供します。

- 有効性: 生成AIシステムが一貫して、自社が意図する価値を生み出すことを確認します。

- 安全性: 有害、または不適切な出力を防ぐことを確認します。

- 公平性: サービス品質や情報源へのアクセスにおいて、公平性が保たれていることを確認します。

- セキュリティ: 悪意ある不正利用者や攻撃者から機密データやシステムを保護できることを確認します。

- コンプライアンス: 法規制、方針、倫理基準を遵守していることを確認します。

ARTKITを活用することで、チームは自らの批判的思考力と創造力を発揮し、潜在的なリスクを迅速に特定・軽減できます。このツールの目的は、ビジネスリーダーや意思決定者が、安全で公平な結果が得られるという確信のもとで、生成AIとBCGのRAIフレームワークの力を最大限に活用し、測定可能な形でビジネス上の成果を生み出せるようにすることです。

AI行動規範の詳細はこちらをご覧ください。

責任あるAI 最近の論考など

AI倫理 エキスパート